机器学习,深度学习,神经网络,深度神经网络之间的区别

先来说一下这几者之间的关系:人工智能包含机器学习,机器学习包含深度学习(是其中比较重要的分支)。深度学习源自于人工神经网络的研究,但是并不完全等于传统神经网络。所以深度学习可以说是在传统神经网络基础上的升级。

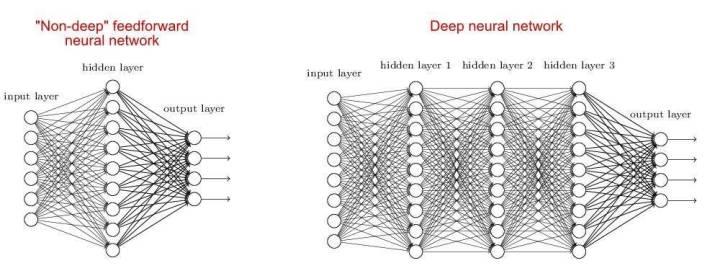

神经网络与深度神经网络的区别在于隐藏层级,通常两层或两层以上隐藏层的网络叫做深度神经网络。

在神经网络与深度神经网络之间,深度神经网络要优于神经网络,因为对某个特定问题而言,隐藏层越多,精确度越高。在其他许多任务和领域中同样可以观察到这个现象。

深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络。它模仿人脑的机制来解释数据,例如图像,声音和文本,是无监督学习的一种。

这就好比一个被清空记忆的人重新开始认知世界,你不能直接告诉他他自己是谁,但是只要给了他足够的信息他就能自己发明和领悟新的信息。

简单的说:深度学习就是如何让机器能够自己掌握学习能力。

深度学习的算法又分很多种,比较典型的四种:卷积神经网络 — CNN, 循环神经网络 — RNN, 生成对抗网络 — GANs, 深度强化学习 — RL。

我们以卷积网络为例。

卷积神经网络是人工神经网络的一种,已成为当前语音分析和图像识别领域的研究热点。它的权值共享网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。该优点在网络的输入是多维图像时表现的更为明显,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。

全链接DNN的结构里下层神经元和所有上层神经元都能够形成连接,带来了参数数量的膨胀问题。例如,1000*1000的像素图像,光这一层就有10^12个权重需要训练。此时我们可以用卷积神经网络CNN,对于CNN来说,并不是所有上下层神经元都能直接相连,而是通过“卷积核”作为中介。同一个卷积核在所有图像内是共享的,图像通过卷积操作后仍然保留原先的位置关系。图像输入层到隐含层的参数瞬间降低到了100*100*100=10^6个 。

卷积网络是为识别二维形状而特殊设计的一个多层感知器,这种网络结构对平移、比例缩放、倾斜或者共他形式的变形具有高度不变性。

卷积网络在本质上是一种输入到输出的映射,它能够学习大量的输入与输出之间的映射关系,而不需要任何输入和输出之间的精确的数学表达式。其优点在于权重共享策略减少了需要训练的参数,相同的权重可以让滤波器不受信号位置的影响来检测信号的特性,使得训练出来的模型的泛化能力更强;池化运算可以降低网络的空间分辨率,从而消除信号的微小偏移和扭曲,从而对输入数据的平移不变性要求不高。

有必要对神经网络、深度学习、机器学习的概念做个简单描述。

神经网络,该模型灵感来自动物的中枢神经系统,通常呈现为相互连接的“神经元”,它可以对输入值通过反馈机制使得它们适应对应的输出。

深度学习是神经网络的进阶版,它的基本思路与神经网络类似,但往往比神经网络有着更复杂的结构以及优化算法,是神经网络的纵向延伸,常见的模型有CNN, RNN, LSTM等。

机器学习是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

接着,阐述神经网络、深度学习、机器学习的区别与联系。

下面的图片很好地描述了这三者之间的关系:

本文系作者在时代Java发表,未经许可,不得转载。

如有侵权,请联系nowjava@qq.com删除。